https://shunsukesaito.github.io/rgca/

Relightable Gaussian Codec Avatars

Relightable Gaussian Codec Avatars are conditioned with a latent expression code, gaze information, and a target view direction. The underlying geometry is parameterized by 3D Gaussians and can be efficiently rendered with the Gaussian Splatting technique.

shunsukesaito.github.io

요약

재조명의 충실도는 기하학적 및 외관 표현 모두에 의해 제한됩니다. 기하학적인 측면에서, 메쉬와 볼륨 접근법 모두 3D 머리카락 구조와 같은 복잡한 구조를 모델링하는 데 어려움을 겪습니다. 외관 측면에서는 기존의 재조명 모델이 충실도가 낮고 고해상도 연속 환경에서 실시간으로 렌더링하기에 너무 느립니다. 이 연구에서는 새로운 표정을 생성할 수 있는 고충실도의 재조명 가능한 머리 아바타를 구축하는 방법인 "Relightable Gaussian Codec Avatars"를 제시합니다. 우리의 3D 가우시안 기반 기하학 모델은 동적 얼굴 시퀀스에서 머리카락 가닥과 모공과 같은 3D 일관성이 있는 서브밀리미터 세부 사항을 캡처할 수 있습니다. 사람의 머리와 같은 다양한 소재(눈, 피부, 머리카락 등)를 통합적으로 지원하기 위해, 학습 가능한 광선 전송을 기반으로 한 새로운 재조명 가능한 외관 모델을 제시합니다. 확산 성분에 대한 전역 조명 인식 구면 고조파와 함께, 우리는 구면 가우시안을 사용하여 모든 주파수 반사를 실시간으로 재조명할 수 있습니다. 이 외관 모델은 점 광원 및 연속 조명 모두에서 효율적으로 재조명될 수 있습니다. 우리는 또한 재조명 가능한 명시적 눈 모델을 도입하여 눈 반사의 충실도를 향상시키고 명시적 시선 제어를 가능하게 합니다. 우리의 방법은 실시간 성능을 손상시키지 않으면서 기존 접근 방식을 능가합니다. 우리는 또한 테더드 소비자 VR 헤드셋에서 아바타의 실시간 재조명을 시연하여 우리의 아바타의 효율성과 충실도를 보여줍니다.

1. 소개

아바타 재조명이 왜 그렇게 어려운가? 우리의 시각적 인식은 얼굴의 외관에 매우 민감합니다. 시각 시스템을 설득하려면 환경과 일관된 충분한 세부 사항으로 머리의 각 부분을 모델링해야 하며, 이는 게임 및 통신 등 포토리얼리스틱 아바타의 주요 응용 프로그램을 위해 실시간으로 수행되어야 합니다【39, 57】. 실감 나는 세부 사항을 가진 애니메이션 가능한 인간 머리의 실시간 재조명은 다음 세 가지 이유로 여전히 열려 있는 과제입니다.

첫 번째 도전 과제는 인간 머리가 서로 다른 산란 및 반사 특성을 가진 매우 복잡하고 다양한 재료로 구성된다는 점입니다. 예를 들어, 피부는 미세 구조로 인해 복잡한 반사를 생성할 뿐만 아니라 상당한 양의 피하 산란을 발생시킵니다【53, 79】. 머리카락은 반투명 섬유 구조로 인해 여러 번 반사와 함께 평면 외부 산란을 나타내고【46】, 눈은 고반사성 막을 가진 여러 층을 가지고 있습니다【33, 68】. 대체로, 이를 모두 정확하게 표현할 수 있는 단일 재료 표현은 없으며, 특히 실시간으로는 더욱 그렇습니다. 게다가, 움직임 중의 기본 기하학을 정확하게 추적하고 모델링하는 것은 매우 어렵습니다. 변형이 항상 추적할 충분한 시각적 마커를 포함하지 않기 때문입니다. 마지막으로, 실시간 요구 사항은 알고리즘 설계를 심각하게 제한합니다. 전통적으로 포토리얼리즘의 증가는 빛의 전송 및 움직임 추적 비용의 기하급수적인 증가로 이어집니다. 우리의 목표는 모든 주파수의 조명 하에서 정확한 산란과 반사를 가진 실시간 렌더링 가능한 머리 아바타를 구축하는 학습 프레임워크를 설계하는 것입니다.

라이트스테이지를 사용하여 얻은 포괄적인 측정치를 고려할 때【10, 16, 45】, 물리 기반 렌더링 방법은 새로운 조명에 일반화할 수 있습니다【69, 79】. 그러나 이러한 방법을 동적 퍼포먼스 캡처와 머리카락 및 눈동자와 같은 비피부 부위에 확장하는 것은 여전히 간단하지 않습니다. 또한, 충분히 정확한 기하학 및 재료 매개 변수를 획득하는 것은 많은 수작업이 필요한 힘든 과정입니다【69】.

최근 들어, 신경망 재조명 접근 방식은 입력(즉, 조명)과 출력(즉, 출사 복사선) 간의 직접적인 관계만을 신경망으로 모델링하고 메쉬【7】, 볼륨 원시 개체【20, 35, 88】 및 신경 필드【33, 67】를 사용하여 기하학을 근사하여 정확한 기하학 및 재료 모델링의 필요성을 우회합니다. 일반적으로 이러한 모델은 라이트스테이지에 의해 제어되는 일등씩(OLAT)【67】 또는 그룹 조명【7, 20, 88】으로부터 학습되며, 연속 조명을 사용한 실시간 렌더링을 지원하려면 비용이 많이 드는 교사-학생 증류【7, 20】 또는 선형성 같은 빛 전송의 주요 특성을 명시적으로 유지하는 물리 기반 외관 모델이 필요합니다【33, 88】. 유망한 결과에도 불구하고, 기존 접근 방식은 기하학적 및 외관 표현의 부족한 표현력 때문에 최적의 성능을 내지 못하는 경우가 많습니다. 특히, 어떤 방법도 머리카락과 눈의 모든 주파수 반사를 달성하지 못하며, 머리카락 가닥과 같은 서브밀리미터 얇은 구조는 종종 흐려지거나 더 큰 덩어리로 합쳐져 머리카락 렌더링이 포토리얼리스틱하지 못합니다.

위에서 언급한 문제를 해결하기 위해 우리는 세 가지 기여를 제시합니다: (1) 정교한 기하학적 세부 사항으로 효율적으로 렌더링할 수 있는 3D 가우시안을 기반으로 하는 구동 가능한 아바타, (2) 실시간으로 전역 광 전송 및 모든 주파수 반사를 지원하는 학습 가능한 광선 전송을 기반으로 한 재조명 가능한 외관 모델, 그리고 (3) 시선 제어와 다른 얼굴 움직임을 분리하고, 모든 주파수 눈 반사를 완전한 데이터 기반 방식으로 가능하게 하는 재조명 가능한 명시적 눈 모델.

3D 가우시안 아바타

우리의 기하학적 표현은 3D 가우시안【24】을 기반으로 하며, 이는 스플래팅을 사용하여 실시간으로 렌더링할 수 있습니다. 구동 가능한 아바타를 달성하기 위해, 우리는 2D 합성곱 신경망을 사용하여 템플릿 머리에 대해 공유된 UV 공간에서 3D 가우시안을 디코딩합니다. 우리는 전통적인 코덱과 유사한 방식으로 얼굴 표정과 같은 구동 신호를 자기 지도 방식으로 인코딩합니다. 이를 통해 머리카락 가닥과 같은 정교한 기하학적 세부 사항으로 시간적으로 일관된 방식으로 움직이는 머리를 추적할 수 있습니다.

학습 가능한 광선 전송

외관 측면에서는 사전 계산된 광선 전송【70】에서 영감을 받아, 학습 가능한 광선 전송을 기반으로 하는 재조명 가능한 외관 모델을 소개합니다. 이 모델은 확산 구면 고조파와 반사 구면 가우시안으로 구성됩니다. 우리는 각 3D 가우시안에 대해 동적 구면 고조파 계수로 매개변수화된 확산 광선 전송을 학습합니다. 이 전송은 가시성 및 다중 반사와 피하 산란을 포함한 전역 광 전송을 사전 합성합니다. 반사 반사에 대해서는 시점 의존 가시성을 가진 새로운 구면 가우시안의 매개변수를 도입하여 폐색, 프레넬 및 기하 감쇠의 결합 효과를 개별 기여도를 명시적으로 추정하지 않고 효과적으로 근사화합니다. 우리의 반사 가우시안 로브는 반사 벡터와 일치하며 시점 방향 및 각 가우시안의 시점 의존 법선을 사용하여 계산됩니다. 가장 중요한 것은, 구면 가우시안이 실시간으로 고해상도 조명 하에서 모든 주파수 반사를 지원한다는 점입니다. 확산 및 반사 표현 모두 빛 전송의 선형성을 만족하므로 추가 훈련 없이 점 광원 및 환경 조명 하에서 실시간 렌더링을 지원합니다. 또한, 제안된 학습 가능한 광선 전송은 전역 광 전송 및 눈, 피부, 머리카락의 모든 주파수 반사를 통합된 표현으로 지원하여 학습 과정을 크게 단순화하면서 매우 높은 충실도의 재조명을 달성합니다.

재조명 가능한 명시적 눈 모델

각막 반사를 재현하기 위해, 우리의 재조명 가능한 가우시안 아바타는 명시적 눈 모델【68】을 통합하여 눈동자의 명시적 제어를 더 잘 분리할 수 있게 합니다. 또한, 우리의 외관 모델은 자연 환경 하에서 포토리얼리즘을 위해 중요한 모든 주파수 반사를 가진 눈의 재조명을 자연스럽게 지원합니다.

우리는 이 연구에서 다양한 기하학적 모델과 재조명 가능한 외관 모델 및 다른 실시간 렌더링 가능한 기준 방법을 평가합니다. 우리의 실험 결과, 3D 가우시안과 우리의 재조명 외관 모델의 조합이 다른 모든 조합을 능가한다는 것을 보여줍니다.

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

프레넬 효과와 기하 감쇠는 빛의 반사와 투과 현상을 설명하는 중요한 물리적 현상입니다. 이 두 가지 효과는 특히 3D 그래픽과 광학에서 사실적인 렌더링을 위해 중요한 역할을 합니다.

프레넬 효과

프레넬 효과(Fresnel Effect)는 빛이 물체의 표면에 입사할 때, 입사각에 따라 반사와 투과의 정도가 달라지는 현상입니다. 이 효과는 다음과 같은 특징을 가집니다:

- 입사각에 따라 반사율 변화: 빛이 표면에 수직으로 입사할 때보다, 비스듬하게 입사할 때 반사되는 빛의 비율이 더 큽니다. 즉, 빛이 표면에 비스듬하게 들어올수록 더 많이 반사됩니다.

- 전반사: 특정 각도 이상에서, 빛이 전부 반사되어 표면을 투과하지 않는 현상이 발생합니다. 이를 전반사(total internal reflection)라고 합니다.

프레넬 방정식을 사용하여 반사율을 계산할 수 있으며, 이는 주로 반사 렌더링과 유리, 물 등의 재질 표현에 사용됩니다.

기하 감쇠

기하 감쇠(Geometric Attenuation)는 빛이 물체의 표면에서 반사되거나 산란될 때, 표면의 기하학적 구조에 의해 빛의 강도가 감소하는 현상입니다. 이 효과는 다음과 같은 요인에 의해 영향을 받습니다:

- 표면의 미세 구조: 표면이 거칠거나 복잡할수록 빛의 산란이 많아져 반사되는 빛의 강도가 감소합니다.

- 입사각과 반사각: 빛이 입사하는 각도와 반사되는 각도에 따라 빛의 경로가 길어지거나 짧아지면서 감쇠 효과가 달라집니다.

기하 감쇠는 주로 표면의 디테일과 광택을 표현하는 데 사용되며, 정확한 반사와 산란을 시뮬레이션하는 데 중요합니다.

결합 효과

프레넬 효과와 기하 감쇠는 함께 작용하여 보다 현실적인 빛의 반사와 투과를 모델링합니다. 예를 들어, 프레넬 효과에 의해 빛이 비스듬하게 입사할수록 더 많이 반사되는 반면, 기하 감쇠에 의해 표면의 거칠기가 빛의 강도를 감소시키는 방식입니다. 이를 결합하여 렌더링하면, 물체의 표면에 입사하는 빛이 어떻게 반사되고 산란되는지를 더욱 정확하게 표현할 수 있습니다.

이 결합 효과는 특히 복잡한 재질(예: 피부, 머리카락, 금속 등)의 렌더링에서 중요하며, 포토리얼리즘을 구현하는 데 필수적입니다. 이 두 가지 현상을 잘 구현하면, 빛의 상호작용을 보다 자연스럽게 표현할 수 있어 더 현실감 있는 이미지를 생성할 수 있습니다.

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

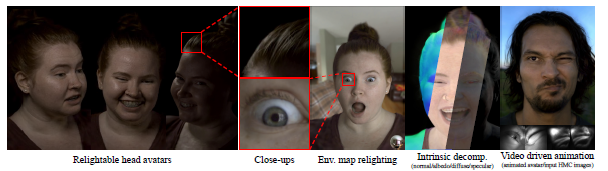

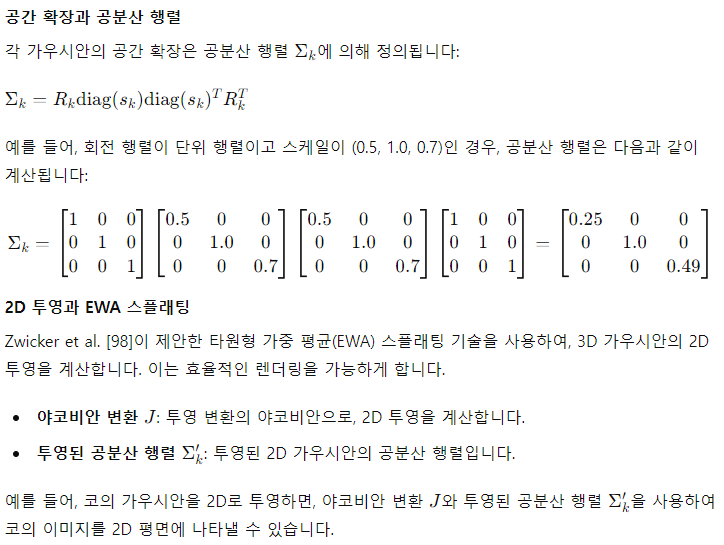

그림 1. 재조명 가능한 가우시안 코덱 아바타

우리의 접근법은 3D 가우시안과 학습 가능한 광선 전송을 사용하여 모든 주파수 반사와 세부적인 머리카락 재구성을 실시간으로 가능하게 합니다. 우리의 동적 아바타는 헤드 마운트 카메라(HMC)로 캡처된 이미지에서 실시간으로 구동될 수 있습니다. 추가 정보

Relightable Gaussian Codec Avatars

Relightable Gaussian Codec Avatars are conditioned with a latent expression code, gaze information, and a target view direction. The underlying geometry is parameterized by 3D Gaussians and can be efficiently rendered with the Gaussian Splatting technique.

shunsukesaito.github.io

2. 관련 연구

얼굴 모델링

얼굴 아바타 모델링은 반세기 이상 활발한 연구 주제였습니다【61】. 예술가 친화적인 3D 얼굴 모델 작성에 대한 연구와 도구에 대한 포괄적인 개요는 【61】을 참고하십시오. 이미지 기반 3D 재구성의 발전【12】으로 다중 뷰 캡처 시스템을 사용하여 3D 얼굴을 정밀하고 더 자동화된 방식으로 획득할 수 있게 되었으며, 이는 특히 고급 영화 제작에서 많이 사용됩니다【2, 4, 9, 16, 91】. 이러한 접근 방식은 주로 얼굴 피부 영역에 초점을 맞추며, 치아【80】, 입술【15】, 얼굴 털【3】, 눈【5, 51】, 머리카락【19, 43, 55, 60】과 같은 다른 구성 요소의 재구성과 모델링을 위해서는 보다 맞춤화된 솔루션이 필요합니다. 이는 동적이고 완전한 머리 아바타를 위해 확장하기 어렵습니다.

최근에는 정확한 입력 기하학 없이 인간 머리를 전체적으로 표현하는 학습 기반 접근 방식이 등장했습니다【39, 44, 95, 97】. 특히, 볼륨 표현【40, 50】은 피부와 머리카락과 같은 더 복잡한 기하학적 구조를 단일 표현으로 나타낼 수 있는 가능성을 보여줍니다【27, 95, 97】. 볼륨을 사용한 실시간 렌더링을 가능하게 하기 위해, 여러 혼합 볼륨 원시 개체【41】 또는 테트라헤드론【14】을 사용하여 공간을 효율적으로 분할하는 하이브리드 접근 방식이 제안되었습니다. 점 구름도 머리 아바타 모델링에 사용됩니다【96】. 그러나 실시간 렌더링 가능한 아바타를 위한 기존의 형태 표현은 머리카락 가닥과 같은 매우 얇은 구조를 모델링하는 데 어려움을 겪고 있습니다. 이러한 제한을 해결하기 위해, 우리는 3D 가우시안 스플래팅【24】을 기반으로 한 최신 효율적인 장면 표현을 애니메이션 가능한 얼굴 아바타 모델링으로 확장합니다. 여러 연구가 이미 3D 가우시안의 동적 모델링을 보여주었지만【42, 81】, 우리는 애니메이션 가능하고 (가장 중요한) 재조명 가능한 3D 가우시안 모델링을 처음으로 가능하게 합니다.

얼굴 반사 캡처

2000년대 초반, 시각적 제작은 배우를 가상 환경에 합성하기 위해 얼굴 반사 캡처 및 재조명 연구의 큰 동력이었습니다. Debevec et al.【10】의 기념비적인 연구는 한 번에 하나의 조명(OLAT) 캡처를 사용하여 반사 특성을 얻고 빛 전송의 선형성을 활용하여 새로운 조명에서 얼굴을 재조명할 수 있음을 보여주었습니다. 후속 연구는 이 방법을 동적 재조명으로 확장하고【62】, 구면 그라디언트 조명을 사용하여 반사 맵을 빠르게 획득하는 방법을 제안했습니다【16, 18, 45】. 이후, 더 큰 데이터셋을 수집함으로써 신경망을 사용하여 단일 이미지에서 반사를 추정할 수 있게 되었습니다【31, 32, 34, 36, 59, 87】. 그러나 정확한 반사 추정은 보통 피부 영역에 국한되는데, 이는 복잡한 머리카락과 눈 구조가 역 렌더링을 불가능하게 만들기 때문입니다. 다양한 장면 표현을 사용한 역 렌더링이 공간적으로 변하는 BRDF(SVBRDF)를 추정하기 위해 제안되었지만【7, 52, 54, 90, 94】, 매우 복잡하고 다양한 재질과 기하학적 구성으로 인해 전체 인간 머리를 포토리얼리스틱하게 모델링하는 것은 여전히 도전 과제입니다. 최근의 재조명 가능한 머리 모델링에서 간단한 BRDF 및 셰이딩 모델을 사용하는 경우에도 포토리얼리즘의 부족이 분명히 드러납니다【11, 65, 96】.

신경망 재조명

BRDF 파라미터를 모델링하는 대신, 학습 기반 재조명 접근법은 라이트스테이지 캡처를 통해 재조명 가능한 외관을 직접 학습하려고 합니다【13, 48, 49, 67, 84, 85, 93】. 이러한 접근법은 정적 장면【67, 84, 85, 93】과 동적 장면【48, 49】에 대해 유망한 재조명을 보여주지만, 아바타에 필수적인 새로운 애니메이션 생성을 지원하지 않습니다. 초상화 재조명 방법【58, 71, 72, 77, 89】도 단일 이미지에서 새로운 조명 하에서 재조명을 가능하게 합니다. 그러나 이 방법들은 새로운 뷰 합성이나 시간적으로 일관된 동적 재조명을 생성할 수 없습니다. Bi 등【6】은 애니메이션 가능한 얼굴 아바타에 대해 전역 조명을 지원하는 신경망 렌더링 방법을 제안했습니다. 자연 환경에서 실시간 렌더링을 가능하게 하기 위해, 그들은 개별 점광원으로 조건화된 느린 교사 모델을 환경 맵으로 조건화될 수 있는 가벼운 학생 모델로 증류했습니다. 이 연구는 후에 관절 손 모델링【20】, 머리와 안경의 구성적 모델링【35】, 교사-학생 증류의 필요성을 제거하여 확장 가능한 훈련으로 확장되었습니다【88】. 이러한 재조명 가능한 아바타는 조명 정보를 입력으로 받으며, 이는 모든 주파수 재조명에서 표현력의 주요 제한 요소임을 발견했습니다. 이에 반해, 사전 계산된 방사 전송(PRT)【70, 75】에서 영감을 받아, 우리는 우리의 신경망 디코더 출력에 목표 조명을 통합하여 품질을 향상시키고 학습 파이프라인을 단순화할 것을 제안합니다.

사전 계산된 방사 전송

컴퓨터 그래픽에서 전역 조명으로 장면을 렌더링하는 것은 반복적인 경로 추적이나 다중 반사 계산으로 인해 비용이 많이 듭니다. Sloan 등【70】은 전역 광 전송으로 실시간 렌더링을 가능하게 하기 위해, 기하학 및 반사와 같은 본질적인 장면 속성에만 의존하는 광 전송의 일부를 사전 계산하고, 실행 시에 사전 계산된 본질적인 요소와 외재적 조명을 통합할 것을 제안했습니다. 빠른 통합을 위해, 그들은 구면 고조파를 각도 기저로 사용했습니다. 구면 고조파의 제한된 주파수 대역을 극복하기 위해, 후속 연구에서는 웨이블릿【56】, 구면 기저 함수【74】, 구면 가우시안【17, 75】, 비등방성 구면 가우시안【82】, 신경망 기반 분해법【86】을 도입했습니다. 유사하게, Neural PRT【63】는 신경망 지연 렌더링【73】을 기반으로 화면 공간 재조명에 동일한 원리를 적용합니다. 많은 바람직한 특성에도 불구하고, 이러한 방법은 기하학과 재질 속성을 아는 것에 의존하기 때문에 주로 정적 장면에 초점을 맞춥니다. 불행히도, 우리는 인간 머리의 기하학과 재질 속성을 미리 알 수 없으며, 그것들은 정적이지도 않습니다. 따라서 우리는 어떤 재질 유형이나 기본 기하학을 명시적으로 가정하지 않고, 동적 실제 데이터 관찰에서 본질적인 방사 전송을 학습할 것을 제안합니다. 외관 표현 측면에서 우리 연구와 가장 유사한 것은 EyeNeRF【33】로, 이들은 이미지 관찰을 통해 확산 성분에 대해 시점 독립적 구면 고조파와 반사 성분에 대해 시점 조건화된 구면 고조파를 학습하여 재조명 가능한 눈 모델을 구축했습니다. 그러나 이 외관 모델은 반사 반사에 대한 구면 고조파의 제한된 표현력으로 인해 한계를 가집니다. 경험적으로, 우리는 그들이 제안한 모델이 새로운 뷰와 조명 방향에 잘 일반화되지 않는다는 것을 발견했습니다. 분석은 4장에서 다룹니다.

3.1 데이터 획득

우리는 [6, 35]와 유사한 설정을 사용하여 110대의 카메라와 460개의 화이트 LED 조명을 사용하여 4096 × 2668 해상도에서 90Hz로 보정되고 동기화된 다중 뷰 이미지를 캡처합니다. 각 참가자는 다양한 얼굴 표정, 문장, 시선 동작 등의 사전 정의된 세트를 수행하도록 요청받으며, 약 144,000 프레임의 데이터를 수집합니다. 다양한 조명 패턴을 수집하고 안정적인 얼굴 추적을 가능하게 하기 위해, 시간 분할 조명을 사용합니다. 특히, 전체 조명은 매 세 번째 프레임에서 교차 점등되며, 나머지는 5개의 조명을 그룹화하거나 무작위로 설정합니다.

[6, 35]와 마찬가지로, 우리는 다중 뷰 전체 조명을 사용하여 위상적으로 일관된 거친 메쉬 추적을 수행합니다. 우리는 또한 Lamarre et al. [30]의 모드 추적 방법을 사용하여 헤드 포즈를 안정화합니다. 두 눈의 시선은 [68]에서 설명한 방법을 사용하여 추정합니다. 추적된 메쉬, 헤드 포즈, 풀린 평균 텍스처 및 시선은 후속 아바타 훈련을 위해 인접한 부분적으로 조명된 프레임에 인터폴레이션됩니다.

3.2 기하학: 3D 가우시안 아바타

우리의 기하학적 표현의 핵심은 3D 이방성 가우시안 [24]의 혼합으로, 다양한 위상을 나타내며 볼륨 구조를 나타낼 수 있습니다. 우리는 먼저 3D 가우시안 스플래팅 [24]의 기본 매개변수화 및 주요 아이디어를 검토한 다음, 애니메이션 가능한 아바타 모델링을 가능하게 하는 주요 변경 사항을 강조합니다.

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

가우시안 정의와 렌더링 예시

가우시안 아바타의 렌더링 과정을 실제 예시를 통해 설명하겠습니다.

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

3.3 기하학: 3D 가우시안 아바타 예시

3D 가우시안 아바타를 매개변수화하기 위해, 우리는 공유된 UV 텍스처 맵과 거친 템플릿 메쉬를 기반으로 3D 가우시안을 매개변수화하고, 2D 합성곱 신경망을 사용하여 그들의 변환과 불투명도를 디코딩합니다. 얼굴 표정은 비선형적이고 정확하게 정의하기 어렵기 때문에, Lombardi et al. [39]와 Xu et al. [83]의 접근법을 따라 조건부 변형 오토인코더(CVAE) [26]를 사용하여 데이터에서 얼굴 표정 분포의 잠재 분포를 학습합니다.

위의 매개변수화는 Volumetric Primitives (MVP) [41]의 혼합과 유사하지만, 두 가지 중요한 차이점이 있습니다:

- MVP와 달리, 우리는 레이마칭을 필요로 하지 않으며, 3D 가우시안을 효율적으로 렌더링하기 위해 스플래팅을 사용합니다.

- 가우시안은 더 날카로운 외관을 제공하여, 머리카락과 같은 얇은 구조를 더 잘 재현할 수 있습니다.

이러한 접근 방식을 통해 3D 가우시안 아바타는 복잡한 얼굴 표정과 다양한 조명 조건에서 사실적이고 고해상도의 외관을 나타낼 수 있습니다.

3.3 외관: 학습 가능한 방사 전송

얼굴의 외관 모델은 피부의 피하 산란, 피부와 눈의 반사 반사, 머리카락의 다중 반사 산란을 포함한 다양한 광 전송 효과를 정확하게 모델링해야 합니다. 초기 연구들에서 논의된 바와 같이 [70, 75], 확산 전송 연산자는 입사 조명의 저역통과 필터링이며, 반사 전송 연산자는 거울과 같은 반사를 위해 모든 주파수 정보를 나타낼 수 있어야 합니다.

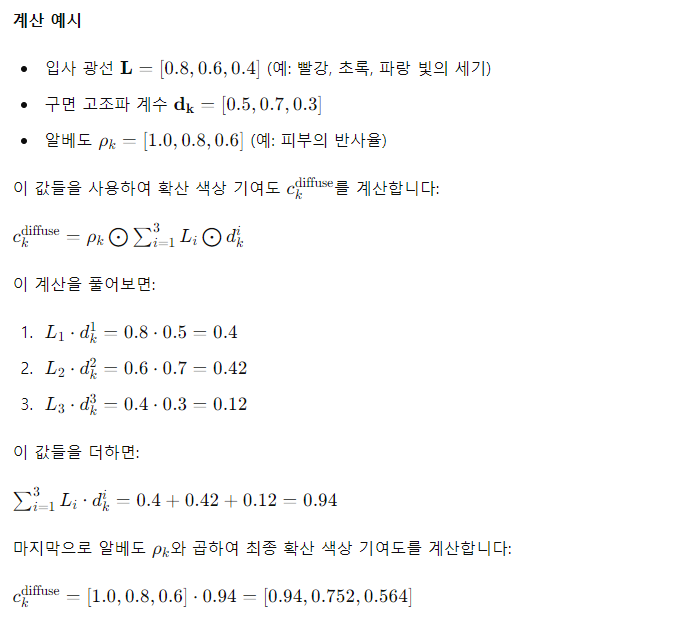

확산 색상

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

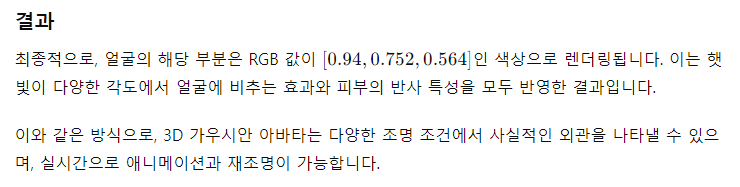

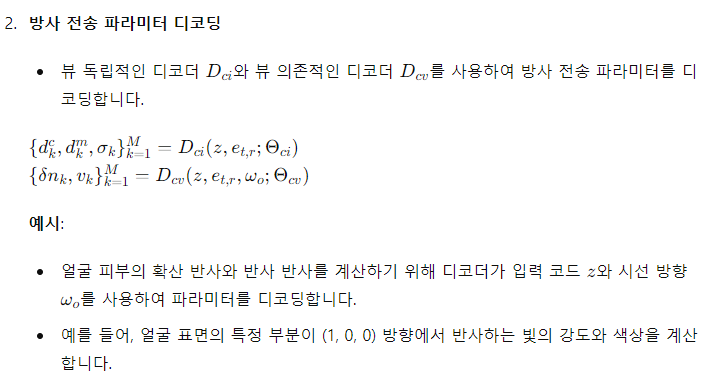

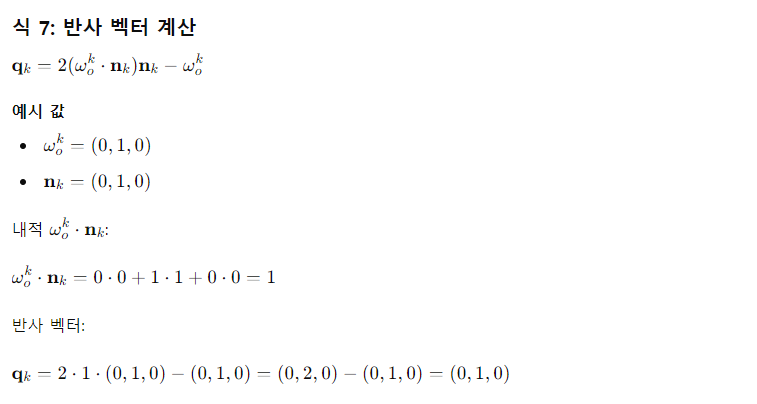

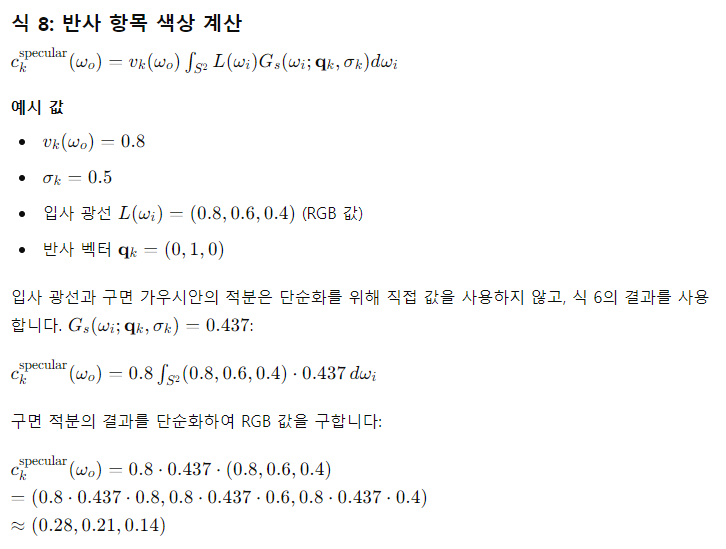

반사 반사 (Specular Reflection)

거울 같은 반사를 달성하기 위해, 뷰 의존적인 반사 항목에는 구면 가우시안(SG)을 각도 기저로 사용합니다. 특히, 우리는 다음과 같은 정규화된 각도 기반 구면 가우시안을 제안합니다:

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

설명

3D 가우시안을 사용한 얇은 섬유 구조 표현

앞서 설명한 공식은 표면에는 잘 작동하지만, 우리는 3D 가우시안을 사용하여 머리카락 가닥과 같은 얇은 섬유 구조도 표현합니다. 식 8은 관찰자가 각 섬유의 접선 벡터를 따라 회전할 때 잘못될 수 있습니다【22】. 표면과 섬유의 반사 반사를 통합된 방식으로 지원하기 위해, 우리는 뷰 조건부 표면 법선을 학습하는 방법을 제안합니다. 학습된 법선은 표면 영역에 대해 뷰 변경 시 일정하게 유지될 수 있지만, 섬유의 경우 뷰 방향에 따라 접선 축을 기준으로 회전할 수 있습니다. 이렇게 하면 각 3D 가우시안이 사전 정의 없이도 기본적인 반사 동작을 유연하게 선택할 수 있습니다. 우리의 학습 가능한 뷰 조건부 법선은 BRDF 로브가 표면 법선과 정확히 일치하지 않는 경우에도 법선 방향을 조정하여 지원할 수 있습니다【46】.

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

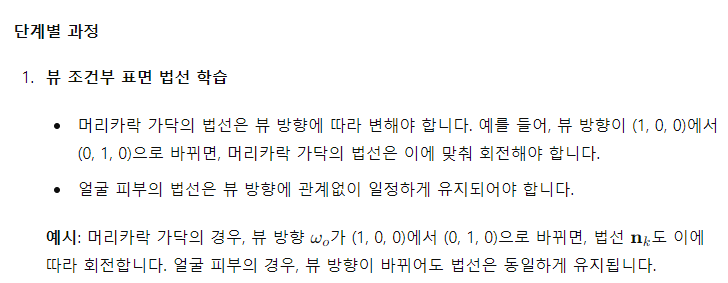

예시: 뷰 조건부 표면 법선 및 방사 전송 파라미터 디코딩

상황 설정

- 머리카락 가닥 표현

- 한 사람의 머리카락 가닥을 3D 가우시안으로 표현합니다.

- 이 가우시안의 법선은 머리카락 가닥의 접선 축을 따라 회전해야 합니다.

- 얼굴 표면 표현

- 같은 사람의 얼굴 피부를 3D 가우시안으로 표현합니다.

- 이 가우시안의 법선은 얼굴의 곡률에 따라 일정하게 유지됩니다.

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

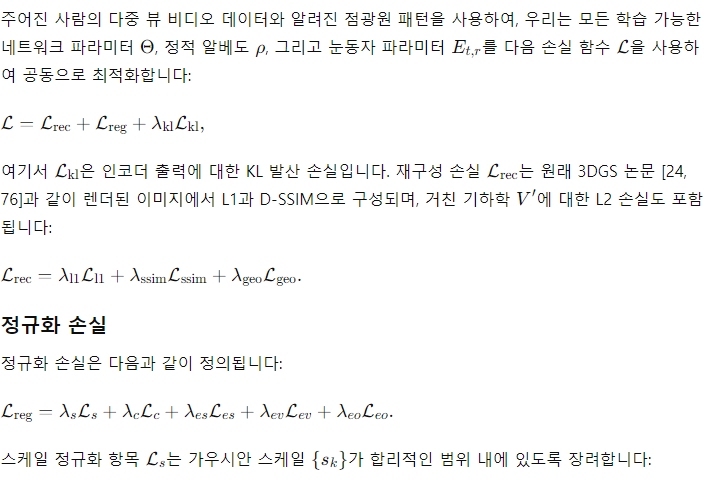

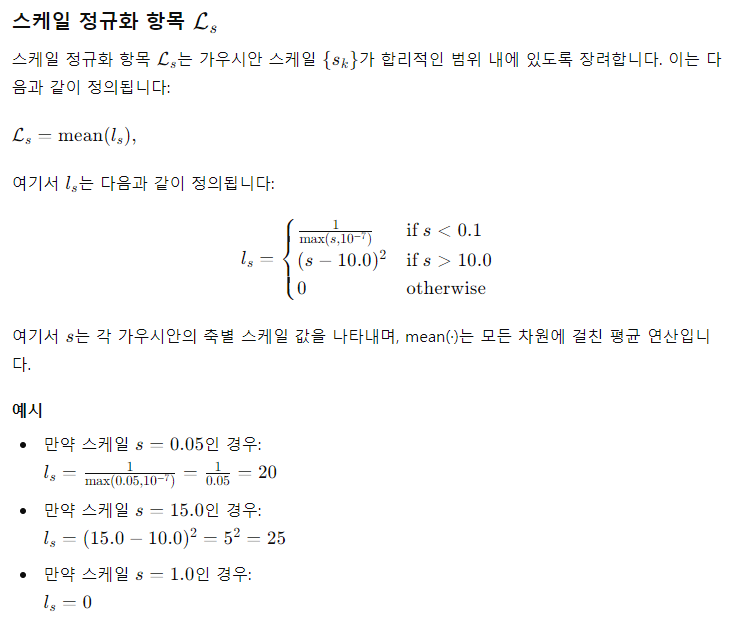

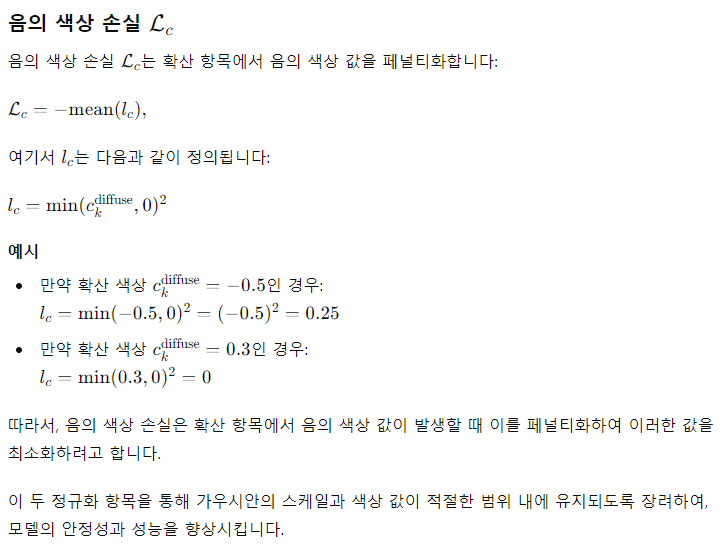

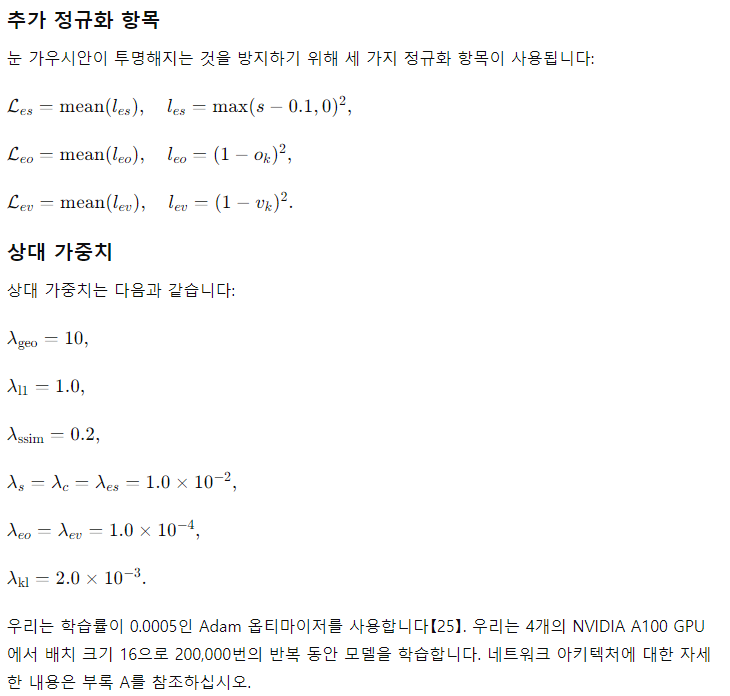

3.5 훈련

4. 실험

평가 프로토콜

정량적 평가를 위해 세 명의 피험자를 선택하고, 정성적 결과를 위해 다양한 인종, 성별, 헤어스타일을 가진 추가 세 명의 피험자를 선택했습니다. 우리의 평가는 약 9,000개의 대화 표현 프레임과 훈련 중에 보지 못한 약 100개의 혐오 표현 프레임을 포함했습니다. 우리는 또한 훈련에서 완전히 제외된 10개의 고유한 정면 조명 패턴을 사용했습니다. 이는 약 144,000개의 프레임 중 약 1,800개의 프레임에 해당합니다. 우리는 PSNR, SSIM, 그리고 LPIPS [92]를 얼굴 영역으로 마스킹된 이미지에서 배경의 영향을 피하기 위해 보고합니다.

4.1. 정성적 결과

그림 1은 우리의 재구성된 아바타가 새로운 시점, 표현 및 조명(점광원과 고해상도 환경 맵을 포함하여)에도 일반화됨을 보여줍니다. 눈에서 환경을 충실하게 표현하며 고주파 세부 사항을 잃지 않는 거울 같은 반사를 확인할 수 있습니다. 우리의 모델은 실시간 재조명을 지원하며, 헤드셋을 통해 실시간으로 구동할 수도 있습니다 [78].

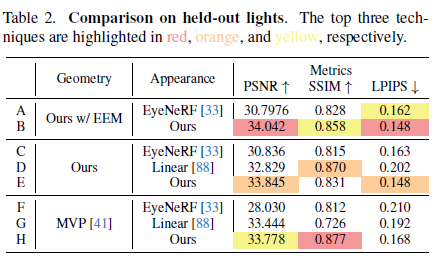

비록 이것이 우리의 주요 목표는 아니지만, 부수적인 결과로서 우리의 접근법은 알베도, 기하학, 표면 법선, 다중 반사 산란, 반사 성분을 포함한 반사의 본질적 특성을 자체 지도 학습 방식으로 추정합니다. 그림 3에서 볼 수 있듯이, 우리의 방법은 3D 일관성과 고충실도의 본질적 분해를 가능하게 합니다.

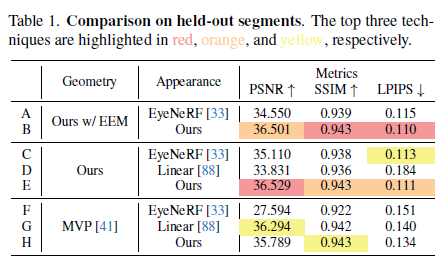

표 1. 홀드아웃 세그먼트에 대한 비교. 상위 세 가지 기술은 각각 빨간색, 주황색, 노란색으로 강조 표시되어 있습니다.

표 2. 홀드아웃 조명 비교. 상위 세 가지 기술은 각각 빨간색, 주황색, 노란색으로 강조 표시되어 있습니다.

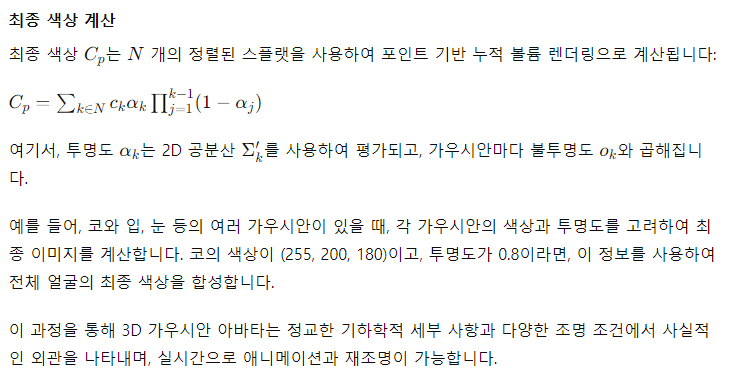

그림 3. 내재적 분해

전체 렌더링 (a)은 확산 성분 (b)과 반사 성분 (c) (명확성을 위해 강도 2배) 을 더하여 생성됩니다. 확산 성분은 학습된 알베도 (d)와 SH 기반 방사 전송으로 계산된 셰이딩 (e)을 곱하여 얻습니다. 반사 로브 방향은 각 가우시안 법선 (f)을 사용하여 계산됩니다.

4.2 논의

기하학적 표현

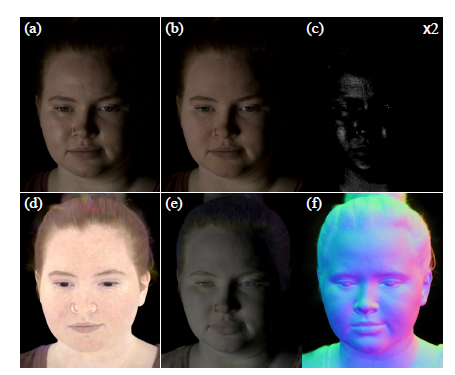

우리는 세 가지 변형을 비교하여 기하학 요소를 평가합니다: 제안된 방법, 명시적 눈 모델(EEM) [68]을 제외한 방법, 그리고 복셀 기반 프리미티브 [41]입니다. 공정한 비교를 위해 동일한 외관 모델을 사용하고 기하학적 표현만 변경했습니다 (표 1 및 표 2 B, D, H). 그림 4는 우리의 3D 가우시안 기반 기하학이 MVP보다 피부 세부 사항과 머리카락 가닥을 더 잘 모델링할 수 있음을 명확히 보여줍니다. 또한, EEM과 결합된 우리의 전체 모델은 눈의 반짝임을 설득력 있게 재현합니다.

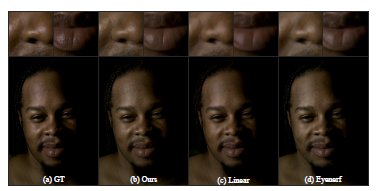

외관 표현

외관 표현의 경우, 우리는 환경 맵을 사용한 실시간 렌더링을 지원하는 기존의 재조명 가능한 외관 표현과 우리의 외관 모델을 비교합니다. Yang et al. [88]이 제시한 모델은 빛의 전송 선형성을 명시적으로 유지하는 선형 신경망(Linear)으로, 이전 최첨단 방법 [6]보다 뛰어난 성능을 보여줍니다. 이 때문에 [6]과의 비교는 생략합니다. 우리의 반사 반사 모델의 효과를 평가하기 위해, 우리는 우리의 반사 성분을 EyeNeRF [33]가 제안한 뷰 의존적 구면 고조파로 대체합니다. 표 1 및 표 2 C, D, E는 우리의 외관 표현이 대부분의 지표에서 기존 외관 모델을 능가함을 보여줍니다. 그림 5에서 볼 수 있듯이, 선형 모델은 전체적인 색상을 정확하게 재현하지만, 재조명 결과는 흐릿하고 고주파 세부 사항이 부족합니다. 이는 주로 병목 조명 표현에 의해 제한됩니다. EyeNeRF의 뷰 의존적 구면 고조파는 더 세부적인 반사를 보여주지만, 반사성에 구면 고조파를 사용하여 표현력이 제한됩니다. 또한, 뷰 의존적 구면 고조파는 과적합에 더 취약하여 애니메이션에서 깜빡이는 아티팩트를 초래합니다. 자세한 내용은 보충 비디오를 참조하십시오. 반면, 구면 가우시안 기반 접근 방식은 대역폭 제한이 없어 고주파 반사를 달성합니다.

데이터 품질의 영향

우리는 우리의 접근 방식이 표정과 상관없이 일반 템플릿 메쉬를 기본 기하학으로 사용하는 것과 같은 더 완화된 설정에서도 작동함을 발견했습니다. 훈련 데이터에서 최대 90%의 카메라 또는 95%의 조명 패턴을 제거해도 작동합니다. 최고의 품질을 달성하기 위해 우리의 설정을 사용하는 것이 좋지만, 이는 제안된 방법이 훨씬 더 간단한 설정에도 적용될 수 있음을 나타냅니다. 실험에 대한 자세한 내용은 부록 C를 참조하십시오.

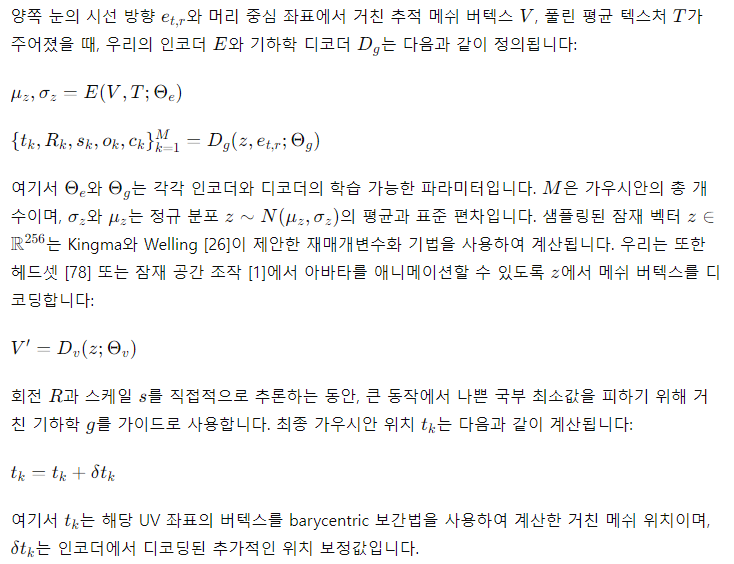

그림 4. 기하학적 표현 비교

보류된 프레임과 비교하여 (a), 우리의 Gaussian splatting 디코딩 기하학 (b,c)은 MVP [41] (d)보다 특히 속눈썹과 모공과 같은 세부 사항에서 향상된 해상도를 보여줍니다. 명시적인 눈동자 모델 (b)은 또한 눈 반짝임의 현실감을 향상시킵니다. 모든 방법은 3.3절에서 설명한 외관 모델을 사용합니다.

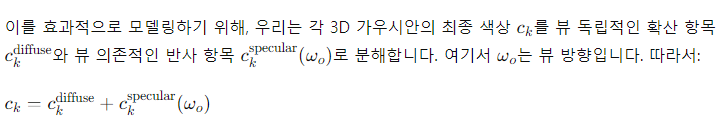

그림 5. 외관 표현 비교

보류된 프레임과 비교하여 (a), 우리의 외관 모델 (3.3절)은 선형 신경망만 사용하는 방법 [88]이나 구면 고조파만 사용하는 "Eyenerf" [33] 방법보다 모공 수준의 반사도가 더 뚜렷하게 나타납니다. 모든 방법은 명시적인 눈동자 없이 3.2절에서 설명한 기하학적 표현을 사용합니다.

5. 결론

우리는 실시간 렌더링을 지원하는 새로운 외관 및 기하학적 표현을 사용한 재조명 가능한 3D 헤드 아바타인 Relightable Gaussian Codec Avatars를 제안했습니다. 우리의 실험 결과는 구면 고조파와 구면 가우시안으로 구성된 제안된 방사 전송 기저를 통해 머리카락, 피부, 눈의 모든 주파수 조명에서 고충실도의 재조명이 이제 실시간으로 가능함을 보여줍니다. 우리는 또한 3D Gaussian Splatting 기반의 기하학적 표현 선택이 가닥 정확도의 머리카락 재구성과 재조명에 중요하다는 것을 증명했습니다. 우리의 접근 방식은 기존의 실시간 렌더링 가능한 기하학적 및 외관 모델에 비해 정성적 및 정량적으로 상당한 품질 향상을 달성했습니다.

한계 및 향후 과제

현재의 접근 방식은 전처리 단계로서 거친 메쉬와 시선 추적을 필요로 하며, 이는 추적 실패에 민감할 수 있습니다. [88]과 유사하게, 토폴로지 일관성 추적 [8, 37, 38]과 함께 엔드 투 엔드 학습은 확장 가능한 훈련을 가능하게 하는 흥미로운 미래 연구 방향입니다. 야생에서의 입력으로 우리의 접근 방식을 확장하는 것도 정확히 알려진 조명 정보의 부족으로 인해 여전히 과제입니다. 마지막으로, 우리의 Gaussian 아바타를 대량으로 렌더링하는 것은 각 3D 가우시안마다 재조명 연산을 수행하기 때문에 어렵습니다. [44]와 유사하게 픽셀 단위 프래그먼트 셰이더에서 계산을 오프로드하는 것도 흥미로운 미래 연구 주제입니다.