취업이 어렵다... 뭐 다들 비슷하겠지만 말이다

https://humanaigc.github.io/chat-anyone/

ChatAnyone

ChatAnyone: Stylized Real-time Portrait Video Generation with Hierarchical Motion Diffusion Model.

humanaigc.github.io

초록

실시간 상호작용이 가능한 비디오 챗(video-chat) 기반의 초상화 생성은, 최근 텍스트 및 음성 기반 챗 기술의 급속한 발전으로 인해 차세대 기술 트렌드로 주목받고 있다. 그러나 기존의 방법들은 주로 실시간으로 머리의 움직임을 생성하는 데 집중하고 있으며, 머리의 움직임과 일치하는 신체 동작을 자연스럽게 생성하는 데 어려움을 겪고 있다. 또한 말하는 스타일이나 미세한 얼굴 표정의 뉘앙스를 정교하게 제어하는 것도 여전히 도전 과제로 남아있다. 이러한 한계를 극복하기 위해 본 논문에서는 실시간 초상화 비디오 생성을 위한 새로운 프레임워크를 제안한다. 이 프레임워크는 단순히 얼굴 움직임에 국한되지 않고, 상반신까지 상호작용이 가능한 표현력 있고 유연한 비디오 챗 환경을 제공한다.

우리의 접근법은 다음 두 단계로 구성된다. 첫 번째 단계는 효율적인 계층적 모션 확산 모델(hierarchical motion diffusion models)을 활용하는데, 이는 음성 입력을 기반으로 명시적(explicit) 및 암묵적(implicit) 모션 표현을 모두 고려하여, 스타일을 제어하면서도 다양한 얼굴 표정을 생성하고, 머리와 신체 움직임 간의 자연스러운 동기화를 가능하게 한다. 두 번째 단계에서는 손짓(hand gestures)을 포함한 상반신 움직임을 초상화 비디오에 구현하는 것을 목표로 한다. 이를 위해 명시적인 손 움직임 제어 신호를 생성기에 주입하여 세부적인 손 움직임을 생성하며, 추가적인 얼굴 정제(face refinement) 작업을 수행하여 초상화 비디오의 현실성과 표현력을 더욱 향상시킨다.

또한 우리의 방법은 최대 512×768 해상도의 상반신 초상화 비디오를 RTX 4090 GPU 환경에서 최대 30fps로 효율적이고 연속적으로 생성할 수 있어, 실시간 상호작용이 가능한 비디오 챗 시스템을 지원한다. 실험 결과는 제안한 방법이 풍부한 표현력과 자연스러운 상반신 움직임을 가진 초상화 비디오를 효과적으로 생성할 수 있음을 입증한다.

그림 1: 실시간 초상화 비디오 생성의 개요. 본 모델은 초상화 이미지와 오디오 시퀀스를 입력으로 받아, 다양한 얼굴 표정과 스타일 제어를 통해 머리 전체부터 상반신 동작까지 고품질로 애니메이션화된 결과를 생성할 수 있다.

1 서론

최근 몇 년간, 대규모 언어 모델(Large Language Models, LLMs) 및 확산 모델(diffusion models)의 급속한 발전은 텍스트 및 음성 챗(chat)의 기능을 크게 향상시켰으며[2, 5], 상호작용이 가능한 인공지능 대화 분야에서 놀라운 성과를 이루었다. 앞으로의 추세를 보면, 비디오 형식으로 제공되는 실시간 상호작용 디지털 휴먼(digital human)은 더욱 몰입감 있고 생생한 상호작용을 약속하며 중요한 기술 트렌드로 떠오르고 있다. 결과적으로, 그림 1에서 볼 수 있듯이 자연스러운 머리 자세(head pose)와 얼굴 표정뿐 아니라 상황에 맞고 유동적인 몸의 움직임까지 결합하여, 사용자가 더욱 사실적이고 몰입할 수 있는 표현력 높은 초상화(portrait) 비디오에 대한 수요가 증가하고 있다.

표현력이 뛰어난 실시간 상호작용 초상화 비디오 생성(real-time interactive portrait video generation)은 언제나 활발히 연구되어온 주제이다. 초기 연구들[21, 34]은 생성적 적대 신경망(Generative Adversarial Networks, GANs)[8]을 활용하여 입술 동기화(lip sync), 즉 입술 영역의 움직임 예측에 중점을 두었다. 이후 연구[41]는 단일 이미지에서 얼굴 표정뿐 아니라 머리 전체의 움직임(head movements)을 생성하는 방향으로 발전하였다. 추가적으로 일부 연구에서는 기본적인 감정 표현 제어[6]를 도입하거나, 간단한 몸동작 생성을 목표로 접근 방식을 확장하기도 했다[36]. 이러한 진전에도 불구하고 세밀하게 감정을 제어하면서 사진과 같은 현실성을 갖춘 초상화 비디오 생성을 달성하는 데는 여전히 많은 어려움이 존재한다.

최근 확산 모델(diffusion models)의 부상으로 인해, 얼굴 및 신체 동작 모두에 대한 높은 표현력을 달성하기 위한 연구가 활발히 진행되었다[26, 27, 4]. 그러나 이러한 방법들은 계산 복잡성과 잡음 제거(denoising) 과정의 반복적(iterative) 특성으로 인해 실시간 추론(real-time inference)에 어려움을 겪고 있어, 상호작용에 요구되는 지연(latency) 조건을 충족하지 못하는 문제가 있다. 앞서 언급된 접근법 외에도, 최근의 몇몇 연구[35, 37]는 가벼운(lightweight) 확산 모델을 설계하여, 확산 모델의 다양하고 표현력 높은 얼굴 움직임 생성 능력을 활용하면서 오디오 입력에서 얼굴 움직임 표현으로의 매핑(mapping)을 학습했다. 이어서 효율적인 GAN을 활용해 고품질의 머리 이미지를 생성하는 방식으로 발전했다.

이러한 방법들은 효율성과 다양성 사이에서 균형을 이루는 데 어느 정도 성공했지만, 표현 강도의 미세한 변화나 특정 개인의 감정 스타일을 정확히 복제하는 등 세밀한(fine-grained) 표현 제어에 있어서는 여전히 한계를 보인다. 또한 고도로 현실적인 텍스처와 세부적인 손짓(hand gestures)의 생성 역시 여전히 어려운 문제로 남아 있다.

이러한 한계를 극복하고 더욱 현실감 있는 실시간 초상화 비디오 상호작용을 달성하기 위해서는 다음의 세 가지 주요 영역에 중점을 둘 필요가 있다.

- 세밀한 표현 제어 및 스타일 전이(fine-grained expression control and style transfer): 얼굴 표정과 머리 자세를 정밀하게 제어하면서, 표현력과 개인화를 높이는 스타일 전이를 가능하게 한다.

- 손짓을 포함한 조화로운 몸의 움직임(coordinated body dynamics): 세부적인 손짓을 포함한 자연스러운 몸의 움직임을 생성하고, 얼굴 표정과의 동기화를 통해 현실적인 상호작용을 가능하게 한다.

- 높은 확장성 및 실시간 추론 효율성(high extensibility and real-time inference efficiency): 머리(head)만 움직이는 애니메이션에서 상반신(upper-body)까지 확장 가능하고, 상호작용 응용 프로그램을 위한 높은 성능과 효율성을 보장한다.

위와 같은 도전 과제에 대응하여, 본 논문에서는 오디오 입력에서 상반신 움직임 표현을 생성하고, 이를 단일 이미지로부터 실시간으로 고품질 초상화 비디오로 변환하는 두 단계로 이루어진 새로운 스타일화된 실시간 초상화 비디오 생성 프레임워크를 제안한다. 우리의 접근 방식은 얼굴 중심의 비디오 챗에서 상반신까지 확장된 표현력과 유연성을 제공함으로써, 디지털 휴먼 상호작용의 현실감과 몰입감을 크게 높인다. 본 연구의 주요 기여는 다음과 같다.

- 첫 번째 단계에서는 오디오 입력을 기반으로 얼굴과 몸의 제어 신호를 계층적으로(hierarchically) 생성하기 위한 효율적인 계층적 모션 확산 모델(hierarchical motion diffusion model)을 제안한다. 이는 명시적(explicit) 및 암묵적(implicit) 모션 신호를 함께 고려하여 정밀한 얼굴 표정을 생성하며, 표현 강도의 미세한 조정 및 레퍼런스 비디오로부터의 스타일 전이를 통한 개인화된 표현을 실현한다.

- 두 번째 단계에서는 명시적 랜드마크(explicit landmarks)를 활용하여 직접적이고 편집 가능한 얼굴 표현을 생성하고, 이에 기반한 암묵적 오프셋(implicit offsets)을 도입하여 다양한 아바타 스타일에 따른 얼굴 변형을 캡처하는 하이브리드 제어 융합 생성 모델(hybrid control fusion generative model)을 설계하였다. 또한 보다 정확하고 현실적인 손 텍스처 및 움직임을 위해 명시적인 손 동작 제어 신호를 주입하였으며, 얼굴 정제 모듈(facial refinement module)을 통해 현실성을 더욱 향상시켜 표현력이 풍부한 초상화 비디오를 구현하였다.

- 인터랙티브 비디오 챗 응용을 위한 확장 가능하고 실시간으로 생성 가능한 프레임워크를 구축하였으며, 유연한 서브모듈(sub-module)의 조합을 통해 얼굴 기반 애니메이션에서 손짓을 포함한 상반신 생성까지 다양한 시나리오에 대응할 수 있다. 또한 효율적인 스트리밍 추론(streaming inference) 파이프라인을 구축하여 RTX 4090 GPU 환경에서 최대 512×768 해상도로 초당 30프레임(30fps)의 속도를 실현함으로써, 매끄럽고 몰입감 있는 실시간 비디오 챗 환경을 제공한다.

본 연구의 실험 결과는 제안한 방법이 풍부한 얼굴 표현력과 상반신 움직임을 모두 갖춘 초상화 비디오를 효과적으로 생성할 수 있음을 입증하였다. 이는 매력적이고 현실감 있는 디지털 휴먼 상호작용의 구현에 크게 기여할 것으로 기대된다.

2 관련 연구

그림 2: 하이브리드 제어 융합(Hybrid control fusion)을 활용한 상반신 비디오 생성 파이프라인. 명시적(explicit) 얼굴 키포인트와 암묵적(implicit) 신체 키포인트를 모두 사용하여 특징 워핑(feature warping)을 수행하며, 손 이미지를 별도로 렌더링하여 생성기에 추가적으로 주입함으로써 손의 표현 품질을 향상시킨다.

본 절에서는 오디오 기반의 초상화 비디오 생성(audio-driven portrait video synthesis)을 위해 두 단계 프레임워크(two-stage framework)를 활용한 기존 방법들을 중점적으로 살펴본다. 이들 방법은 대체로 첫 번째 단계에서 오디오 입력으로부터 움직임 표현(motion representations)을 생성하고, 두 번째 단계에서 생성된 움직임 표현을 고품질의 디지털 휴먼(digital human) 비디오로 변환하는 과정을 따른다.

2.1 오디오 기반 움직임 표현(Audio to Motion Representation)

첫 번째 단계는 오디오 입력을 세부적인 얼굴 움직임 표현(motion representation)으로 변환하는 과정으로, 이를 달성하기 위한 다양한 기법들이 제안되었다. 초기 연구[42, 22, 41]는 3차원 형태 변화 얼굴 모델(three-dimensional morphable face models, 3DMMs)의 파라미터를 사용하여 얼굴 움직임을 표현하였다. 이 방법들은 얼굴의 정체성(identity), 표정(facial expressions), 머리 자세(head pose)를 별개의 계수(coefficients)로 분해하여 각 요소를 독립적으로 제어할 수 있게 했다. 그러나 3DMM 기반 방법은 파라미터화된 얼굴 모델의 한계로 인해 세밀한 얼굴 세부 표현(fine-grained facial details)을 포착하는 데 제한이 있었다.

이후의 연구[44, 33]에서는 명시적(explicit)인 얼굴 랜드마크(facial landmarks)나 메쉬(mesh)를 제어 신호로 도입하여 더 유연하고 표현력 있는 표현 방식을 제공하고, 인간이 아닌 캐릭터(non-human characters)의 얼굴 제어까지 가능하게 하는 강력한 일반화 능력을 보였다. 그러나 이러한 랜드마크 기반 방법들도 여전히 미묘한 얼굴 표정의 변화나 뉘앙스를 포착하는 데 어려움이 남아있다.

최신 연구들은 더 나은 얼굴 표정 제어를 위해 암묵적(implicit)인 제어 신호, 즉 암묵적 키포인트(implicit keypoints)나 움직임 잠재 변수(motion latent variables)를 사용하는 방식을 제안하였다. 예를 들어, EAT [6]와 Ditto [14]는 얼굴 움직임을 제어하기 위해 3D 암묵적 키포인트를 사용하고 추가로 감정 레이블(emotion label)을 조건으로 활용하였다. AniTalker [16]와 VASA-1 [35]은 비디오 시퀀스에서 더 세부적인 움직임을 포착하기 위한 암묵적 움직임 잠재 변수를 추출하고, 감정 표현이 풍부한 얼굴 움직임 생성을 위한 확산 모션 생성기(diffusion motion generator)를 구성하였다. 그러나 완전히 암묵적인 움직임 표현 방법들은 정체성과 표정을 완벽히 분리하는 데 어려움이 있으며, 이로 인해 표정 변화와 함께 의도치 않게 정체성이 변화하는 잠재적 아티팩트(artifact)가 발생할 수 있다.

이러한 한계를 극복하기 위해, 우리는 명시적 및 암묵적 움직임 표현의 상호 보완적 장점을 최대한 활용할 수 있도록 두 가지 표현을 결합한 하이브리드 멀티모달(hybrid multimodal) 모델을 탐구한다. 얼굴 표정뿐 아니라 최근 연구들[36, 4, 27]은 상반신 움직임(upper-body movements)을 위한 제어 신호까지 확장하여 예측하였으나, 얼굴과 몸 움직임 간의 효과적인 협력(coordination)을 이루는 데는 여전히 추가적인 탐구가 필요하다.

2.2 초상화 비디오 생성(Portrait Video Generation)

두 번째 단계는 오디오 입력으로부터 첫 번째 단계에서 예측한 움직임 표현(motion representations)을 조건으로 하여, 고품질의 디지털 휴먼(digital human) 비디오 프레임을 생성하는 과정에 초점을 둔다. 이 분야의 초기 연구[44, 18]는 주로 생성적 적대 신경망(Generative Adversarial Networks, GANs)[8]을 사용하여 초상화 비디오 프레임을 생성했다. 또한 일부 연구자들은 워핑 기반 방법(warp-based methods)[6, 16, 35, 36]을 탐색하여, 소스 이미지로부터 타겟 이미지로의 밀집 모션 플로우(dense motion flow)를 학습해 이미지의 품질과 세부 디테일 보존 측면에서 좋은 성과를 얻었다. 그러나 GAN 기반의 방법은 생성력이 우수함에도 불구하고 얼굴 표정 및 몸의 움직임과 같은 복잡한 상호작용에서 고품질의 디테일을 생성하는 데 여전히 한계가 존재한다.

신경 렌더링(neural rendering) 기술이 등장하면서 몇몇 방법들은 Neural Radiance Fields (NeRF)[10, 17, 38]나 Gaussian Splatting[39]과 같은 기법을 초상화 비디오 생성에 채택하였으며, 이는 기존 대비 뛰어난 렌더링 품질(rendering quality)을 제공하였다. 신경 렌더링 기반 방법들은 매우 사실적인(photorealistic) 초상화 비디오 생성이 가능하며, 동시에 실시간 생성도 지원한다. 하지만 이러한 방법들은 특정 캐릭터마다 재학습(retraining)이 필요한 단점이 있어 확장성(scalability)에 제약이 따른다.

최근 들어 확산 모델(diffusion models)은 고품질 디지털 휴먼 비디오 생성 분야에서 뛰어난 진전을 보여주었다. AniPortrait[33], Vlogger[4], EMO2[27] 등의 방법들은 얼굴 또는 몸의 제어 신호를 denoising UNet 및 참조 네트워크(reference net)에 주입하여 말하는 초상화 비디오를 생성하였다. 그러나 확산 모델은 긴 비디오를 안정적이고 효율적으로 생성하는 데 어려움이 있으며, 추론 과정(inference process)이 연산 집약적(computationally intensive)이고 느리기 때문에 실시간 생성(real-time generation)이 어렵다.

위의 방법들이 가진 장단점을 고려하여, 본 논문에서는 얼굴과 상반신 모두에서 추론 효율성과 성능 사이의 균형을 맞추기 위해 GAN을 주요 생성기로 선택하였다.

3 방법론

본 논문에서 제안하는 방식은 오디오 입력을 기반으로 고품질의 스타일화된 초상화 비디오를 생성한다. 모델은 캐릭터 이미지(머리만 또는 상반신 이미지)와 오디오 클립을 주요 입력으로 하며, 선택적으로 스타일 전이를 위한 레퍼런스(reference) 비디오를 입력으로 받을 수 있다. 생성 과정은 크게 두 단계로 구성된다. 첫 번째 단계에서는 입력된 오디오를 얼굴 표정과 몸 움직임을 포함한 모션 표현(motion representations)으로 변환하고, 두 번째 단계에서는 이 모션 표현과 캐릭터 이미지를 기반으로 초상화 비디오를 합성한다. 만약 레퍼런스 비디오가 제공될 경우, 이를 바탕으로 생성된 비디오가 원하는 스타일을 반영할 수 있도록 스타일 전이가 이루어진다.

다음의 하위 절(subsections)에서 본 접근 방식에 대한 사전 지식(preliminaries)을 먼저 제시한 후, 모션 표현 학습(motion representation learning)을 소개한다. 이어서 오디오 입력에서 모션 표현을 생성하는 모듈을 설명하고, 마지막으로 모션 표현을 기반으로 한 비디오 생성 방법을 서술한다.

3.1 사전 지식 (Preliminaries)

본 연구는 생성된 비디오의 품질과 모델의 추론 성능 간의 균형을 맞추기 위해 기존 연구[30, 9]에서 영감을 얻은 워핑 기반 GAN 프레임워크(warping-based GAN framework)를 채택하였다. 그림 2에 나타낸 것처럼 전체 프레임워크는 네 가지 주요 구성 요소로 이루어져 있다:

- 외형 특징 추출(Appearance feature extraction): 원본 이미지로부터 시각적 특징을 추출한다.

- 모션 표현 추출(Motion representation extraction): 얼굴 표정과 몸 움직임을 나타내는 모션 표현을 추출하며, 이는 3.2절에서 설명한다.

- 워핑 필드 추정(Warping field estimation): 원본 이미지에서 타겟 이미지로 변환하기 위한 워핑 필드(warping field)를 계산한다.

- 생성기(Generator): 워핑된 외형 특징을 기반으로 최종 이미지를 합성하며, 이는 3.4절에서 다룬다.

3.2 모션 표현 (Motion Representation)

얼굴 및 상반신 움직임의 표현력(expressiveness)과 제어 가능성(controllability) 사이의 균형을 맞추기 위해 기존의 방법들에서 널리 사용되는 세 가지 형태의 모션 표현 방식을 고려하였다. 명시적(explicit) 키포인트[13]와 신체 템플릿(body templates)[45]은 움직임에 대한 명확하고 편집 가능한 제어를 제공하는 반면, 암묵적(implicit) 키포인트[9]는 보다 풍부한 세부 정보를 제공한다. 본 논문에서는 이 세 가지 표현의 장점을 모두 활용하기 위해 이를 결합한 하이브리드 표현 방식을 채택하였다. 구체적으로, 머리 움직임은 3D 형태 변화 얼굴 모델(3DMM head template)[29]에서 투영된 3D 키포인트를 사용하여 표현하고, 상반신 움직임은 암묵적 키포인트로부터 도출하며, 손의 움직임은 MANO 템플릿[23] 기반으로 렌더링된 이미지를 통해 캡처한다.

손 움직임

손 움직임 표현의 경우, MANO 템플릿으로부터 얻은 손 계수(hand coefficients)를 사용하여 고해상도의 텍스처를 가진 손 이미지를 렌더링하고 이를 제어 신호(control signals)로 활용한다. 픽셀 단위로 정렬된(pixel-aligned) 손 제어 신호는 손의 형태를 유지하고 고품질의 손 동작을 생성하는 데 특히 유리하다.

그림 3: 계층적 오디오 기반 모션 확산 모델(hierarchical audio2motion diffusion model)의 개요. 하단부에는 스타일 제어가 가능한 얼굴 움직임 예측 모듈이, 상단부에는 손 동작을 포함한 상반신 움직임 예측 모듈이 위치한다.

3.3 오디오에서 모션 표현으로의 변환(Audio to motion representation)

상반신 움직임을 효과적으로 생성하기 위해, 본 논문에서는 계층적(hierarchical) 모델을 설계하였다. 이는 인간의 상반신 움직임이 주로 머리 움직임에 의해 유도되며, 손의 움직임은 주로 오디오 신호의 리듬을 따라 이루어진다는 관찰에 기초하고 있다. 따라서 그림 3에서 보듯, 제안된 계층적 오디오 기반 모델은 먼저 오디오 입력으로부터 얼굴 움직임을 예측한 후, 이 얼굴 움직임을 기반으로 상반신(손 포함) 움직임을 예측한다.

스타일 제어를 통한 얼굴 움직임 예측

첫 번째 하위 단계(sub-stage)에서는 얼굴 움직임이 오디오 입력에서 직접 예측된다. 특히, 모델 학습을 단순하고 효율적으로 만들기 위해, 본 연구에서는 얼굴 움직임 표현으로 헤드 템플릿[29]에 정의된 표현 블렌드쉐입(expression blendshapes)과 회전 및 이동을 포함한 6차원 포즈 계수(6-dimensional pose coefficients)를 사용하였다. 입력된 오디오 클립에서, Transformer 기반 음성 인식 모델[7]을 사용하여 오디오 특징을 추출하며, 이는 입술의 움직임 및 얼굴 표정 생성을 위한 풍부한 의미적(semantic) 정보를 제공한다.

얼굴 움직임 생성의 핵심 모델로는 확산 Transformer(diffusion transformer)[20]를 사용하며, 교차 어텐션(cross-attention) 메커니즘을 통해 오디오 특징을 네트워크에 주입한다. 또한, 연속적인 프레임 간의 부드러운 전환을 보장하기 위해 이전 움직임 정보를 교차 어텐션을 통해 결합하여 시간적 일관성(temporal coherence)을 유지하였다. 스타일 제어를 위해, 얼굴 움직임의 진폭(amplitude)을 정밀하게 제어할 수 있도록 표현 및 포즈 범위에 대한 대략적인(coarse-grained) 정보를 적응형 레이어 정규화(Adaptive Layer Normalization, AdaLN)를 통해 네트워크에 주입한다. 추가적으로 선택적인 스타일 전이를 위해 레퍼런스 비디오로부터 3D 얼굴 재구성 기법으로 추출한 얼굴 표현 시퀀스를 입력할 수 있다. 이 레퍼런스 시퀀스는 시간 축을 따라 노이즈 잠재 표현(noise latent)과 결합되어, 최종 출력물에 원하는 스타일을 효과적으로 전이할 수 있으며, 이를 통해 높은 제어력을 가진 얼굴 표현 생성을 지원한다.

손을 포함한 상반신 움직임 예측

두 번째 하위 단계에서는 앞서 예측한 얼굴 움직임을 상반신 움직임으로 확장한다. 얼굴 계수(coefficients)와 신체 키포인트 간의 차이를 고려하여, 그림 3 상단부에서 나타난 것처럼, 얼굴 움직임 계수를 먼저 헤드 템플릿을 통해 3D 키포인트로 투영한다. 투영된 키포인트는 Transformer 네트워크의 조건으로 사용되며, 동시에 앞서 언급한 오디오 특징과 원본 이미지로부터 얻은 외형(appearance) 특징도 교차 어텐션을 통해 주입된다.

3.4 비디오 생성(Video Generation)

모션 표현을 기반으로 상반신 이미지를 생성하기 위해 본 논문에서는 [9]와 유사한 워핑 기반 GAN(warping-based GAN) 프레임워크를 사용하였다. 전체 과정은 상반신 이미지 생성과 얼굴 정제(face refinement)의 두 단계로 나뉘며, 두 단계는 유사한 네트워크 구조를 공유한다.

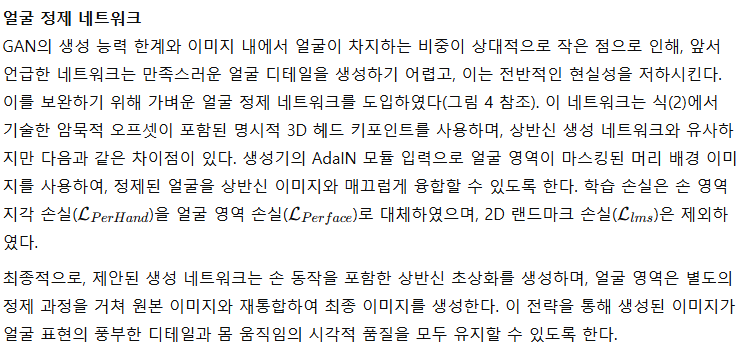

그림 4: 얼굴 정제 네트워크(face refine network)의 개요. 좌측은 네트워크 구조를, 우측은 암묵적 오프셋(offset)을 추가하여 보다 정밀한 얼굴 키포인트를 포착하는 방식을 나타낸다.

표 1: 정량적 평가 결과 (생략된 표 내용은 원문 참조). * 표시는 암묵적 얼굴 키포인트 오프셋의 유효성을 검증하기 위한 얼굴 중심 재현 모드 평가 결과를 나타낸다.

4 실험(Experiments)

본 절에서는 실험 설정과 결과를 소개한다. 먼저 구현 세부사항을 설명한 후, 기존 방법들과 비교하여 비디오 기반(video-driven) 및 오디오 기반(audio-driven) 설정에서의 결과를 제시한다. 마지막으로 다양한 모듈의 유효성을 검증하기 위한 제거(ablation) 실험을 진행한다.

4.1 구현 세부사항(Implementation Details)

본 논문에서는 오디오 기반의 움직임 표현 생성(audio-driven)과 비디오 생성(video generation)을 위한 두 단계 모델을 독립적으로 훈련하였다. 오디오에서 움직임 표현을 생성하는 단계에서는 얼굴 계수를 예측하기 위해 6개의 레이어로 구성된 확산 트랜스포머(diffusion transformer)를 사용하였고, 상반신 움직임 예측 모델은 2개의 레이어로 구성된 트랜스포머를 사용하였다. 두 모듈 모두 A100 GPU 환경에서 배치 사이즈(batch size) 16으로 100K 스텝(step) 동안 학습하였다. 비디오 생성 단계에서는 생성 이미지가 상반신인지 머리만 포함된 이미지인지에 따라 서로 다른 해상도를 사용하였다. 상반신 이미지는 512×768 해상도로, 머리만 포함된 이미지는 512×512 해상도로 출력된다. 모든 모델은 Adam 최적화 알고리즘을 이용하여 학습률 1e-4로 설정하고, 8개의 A100 GPU 환경에서 배치 사이즈 32로 7일간 훈련하였다. 추론(inference) 단계에서는 비디오 생성 모듈이 순차적으로 작동하며, RTX 4090 GPU 환경에서 초당 30 프레임(30fps)의 실시간 추론 속도를 달성하였다. 보다 자세한 구현 사항과 추론 파이프라인은 보충 자료(supplementary materials)에 제시하였다.

훈련 및 테스트 데이터는 유튜브(YouTube)에서 약 20,000개의 토크쇼 비디오 클립을 수집 및 정제하여 총 약 30시간 분량(30fps)의 데이터를 확보하였다. 그 중에서 기존 방법과의 비교 및 제거 실험을 위한 테스트로 500개의 클립을 무작위로 선정하였다.

표 2: 확산 모델 기반(diffusion-based) 방법과의 비디오 생성 정량적 비교. 비교 대상 방법에서 제공된 데모 비디오를 재현(reenact)하여 손 생성 결과를 평가하였다.

4.2 비디오 생성 결과(Video Generation Results)

GAN 기반의 상반신 오디오 기반(upper-body audio-driven) 연구가 제한적임을 고려하여, 우리는 먼저 자체 재현 설정(self-driven reenactment)을 통해 제안된 비디오 생성 모델의 상반신 비디오 생성 성능을 독립적으로 검증하였다. 이는 상반신 오디오 기반 시나리오에서 최종 생성된 초상화 비디오의 품질에 직접적인 영향을 미치기 때문에 매우 중요하다. 본 논문에서는 기존의 GAN 기반 비디오 재현(video-driven) 방식인 FOMM[24], MRAA[25], LIA[31], TPSMM[43] 등과 비교하였으며, 생성된 프레임의 품질 평가를 위해 PSNR(Peak Signal-to-Noise Ratio), SSIM(Structural Similarity Index)[32], LPIPS(Learned Perceptual Image Patch Similarity)[40], FID(Fréchet Inception Distance)[11], FVD(Fréchet Video Distance)[28]와 같은 여러 지표를 사용하였다. 또한, 레퍼런스 이미지와 생성된 비디오 프레임 간의 코사인 유사도(CSIM)를 계산하였으며, 생성된 프레임에서 손 표현의 품질을 평가하기 위한 손 키포인트 신뢰도(Hand Keypoint Confidence, HKC)도 측정하였다.

정량적 비교 결과는 표 1에 제시하였으며, 그림 5에서 시각적인 예시를 통해 정성적 비교 결과를 추가로 제공하였다. 결과에서 보듯이, 제안한 방식은 명시적(explicit) 및 암묵적(implicit) 모션 표현의 하이브리드 제어 융합(hybrid control fusion)을 통해 기존 방법 대비 상반신 생성 품질에서 뚜렷한 우위를 보였다. 특히, 손 생성 품질에서 월등한 성능을 보였으며, 이는 렌더링된 손 이미지를 추가 정보로 활용하여 고품질 손 생성을 구현한 제안 방식 덕분이다.

추가로 표 2에서 최신 확산 모델 기반(diffusion-based) 방법인 CyberHost[15], EchoMimicV2[19]와도 비교하여 상반신 및 손 생성 성능을 평가하였다. 비교 결과, 제안된 방법이 확산 모델 기반 방식과 견줄 수 있는 경쟁력 있는 결과를 달성함을 확인하였다. 또한, 추론 속도(FPS)는 표 1에서 함께 제시되었는데, 기존 방법들이 더 높은 FPS를 달성했으나 출력 해상도가 상대적으로 낮았다. 반면 본 논문의 접근법은 더 높은 해상도에서도 초당 30프레임 이상의 실시간 추론 성능을 달성함과 동시에 뛰어난 정량적 성능을 보여, 품질과 효율성 간의 균형을 이룬 실제 응용(application)에 적합한 모델임을 입증하였다.

그림 5: 자체 재현(self-driven reenactment) 설정에서의 상반신 비디오 생성에 대한 정성적 비교 결과. 본 논문의 접근법은 기존 GAN 기반 비교 방법들보다 뛰어나며, 확산 모델 기반 EchoMimicV2와 유사한 품질을 달성하였다.

표 3: 머리만 포함된 말하기(head-only talking animation) 오디오 기반 애니메이션 생성 결과의 정량적 비교 결과.

4.3 오디오 기반 결과(Audio-driven Results)

본 절에서는 오디오 기반 초상화 비디오(audio-driven portrait video) 생성 결과를 비교하며, 특히 입술 동기화(lip-sync)의 정확성과 움직임 다양성(motion diversity)에 중점을 둔다. GAN 기반으로 오디오 기반 상반신 움직임 생성을 직접적으로 다룬 연구가 제한적인 관계로, 본 논문에서는 GAN 기반 말하는 얼굴(talking head) 생성 방법들인 SadTalker[41]와 AniTalker[16]를 주요 비교 대상으로 선정하여, 오디오 기반 조건에서의 얼굴 생성 품질을 중점적으로 평가하였다. 평가 지표로는 앞서 언급한 이미지 품질 지표뿐만 아니라, 입술 움직임과 오디오 신호의 동기화를 평가하는 SyncNet[3] 기반의 Sync 지표와 얼굴 키포인트 변동성(face keypoint variance)을 사용하여 얼굴 움직임의 다양성을 측정하였다.

정량적인 실험 결과는 표 3에 제시하였으며, 서로 다른 방법들로 생성한 말하는 얼굴 비디오의 시각적 비교는 보충 자료(supplementary materials)에 제공하였다. 이 정량적 비교와 시각적 예시를 통해 비교 대상 방법들 간의 입술 동기화 정확도와 움직임 다양성의 차이를 명확히 확인할 수 있다. 실험 결과 본 논문에서 제안한 방법이 기존 방법들을 능가하여, 입술 움직임이 오디오 신호와 더욱 정확히 일치하고 얼굴 표정이 더욱 다양함을 입증하였다. 이러한 성능 향상은 명시적(explicit) 및 암묵적(implicit) 제어 신호를 효과적으로 결합하여 더욱 정교하고 표현력 있는 얼굴 및 신체 움직임을 생성하는 제안된 계층적 모션 확산 모델(hierarchical motion diffusion model)에 기인한다.

4.4 제거 실험(Ablation Studies)

본 논문에서 제안한 다양한 하위 모듈(sub-module)들의 효과를 평가하기 위해 종합적인 제거 실험(ablation study)을 수행하였다. 구체적으로, 얼굴 스타일 제어와 스타일 전이의 효과, 명시적(explicit) 및 암묵적(implicit) 하이브리드 제어 융합(hybrid control fusion)의 영향, 손 신호 주입(hand signal injection)의 효과, 얼굴 정제(face refinement) 모듈의 성능을 검증하였다. 이러한 제거 실험의 시각적 비교 결과는 보충 자료(supplementary materials)에 추가로 제공하였다.

표 4: 레퍼런스 스타일 전이(reference style transfer) 효과 비교. 오디오에서 모션으로 예측된 얼굴 계수(face coefficients)를 기반으로 계산되었다.

얼굴 스타일 제어 및 전이(Facial Style Control and Transfer)

얼굴 표정의 스타일 제어와 스타일 전이 능력을 평가하였다. 우선, 레퍼런스 비디오로부터 추출한 표정 움직임 시퀀스를 최종 생성된 얼굴 계수에 주입하는 효과를 비교하였다. 생성된 얼굴 계수와 실제(ground-truth) 사이의 유사성은 MAE(평균 절대 오차)와 SSIM 지표로 측정하였다. 표 4의 결과는 레퍼런스 비디오로부터의 표정 정보를 주입하는 것이 실제와의 유사성을 크게 높인다는 것을 보여준다. 이는 레퍼런스 비디오의 표정 스타일이 효과적으로 생성 결과에 전이된다는 것을 의미한다. 또한 보충 자료에 제공된 정성적 비교 결과는 표현 강도를 명시적으로 제어할 때의 효과를 추가로 입증한다.

명시적 및 암묵적 하이브리드 제어 융합(Explicit and Implicit Hybrid Control Fusion)

명시적 키포인트에 암묵적 키포인트 오프셋(offset)을 결합하는 것이 얼굴 표정 이미지 생성에 미치는 영향을 평가하였다. 특히, 식(2)에서 기술한 암묵적 키포인트 오프셋 사용 유무에 따라 결과를 비교하였다. 표 1에서 보듯이, 암묵적 키포인트 오프셋을 포함할 때 얼굴 표현 이미지의 품질과 정확도가 향상되었으며, 이는 하이브리드 제어가 오디오 기반 얼굴 표현의 유연성과 다양성을 증가시키면서 동시에 높은 제어 가능성을 유지함을 시사한다.

손 신호 주입(Hand Signal Injection)

손 제어 신호를 주입하는 것이 상반신 이미지 생성 품질에 미치는 영향도 조사하였다. 표 1의 결과에 따르면, 손 제어 신호를 주입하지 않은 경우 이미지 품질이 현저히 떨어지는 것으로 나타났다. 이는 손 제어 신호 주입이 정확하고 명확한 손 움직임을 생성하는 데 필수적인 역할을 하며, 생성된 상반신 이미지의 현실성과 일관성을 크게 향상시킨다는 점을 보여준다.

얼굴 정제(Face Refinement)

마지막으로 얼굴 정제 모듈의 유효성을 평가하였다. 표 1의 결과는 얼굴 정제를 적용했을 때 생성된 얼굴 이미지의 품질이 뚜렷하게 개선됨을 나타낸다. 이는 얼굴 정제가 초상화 비디오의 얼굴 영역 품질을 향상시켜, 전체적인 현실성과 표현력을 높임을 보여준다. 향상된 얼굴 세부 표현은 상반신 초상화 비디오의 생동감을 더욱 높이는 데 기여한다.

5 결론(Conclusion)

본 논문에서는 계층적 모션 확산(hierarchical motion diffusion) 기반 오디오 구동 모델과 하이브리드 제어 융합(hybrid control fusion) 비디오 생성 모델을 결합한, 새로운 스타일화된 초상화 비디오 생성 방법을 제안하였다. 우리가 제안한 두 단계의 확장 가능한(extensible) 프레임워크는 머리 중심 애니메이션에서 손 동작을 포함한 상반신 비디오까지 다양한 작업을 지원하며, 표현력이 뛰어난 생동감 있는 초상화 비디오를 생성한다. RTX 4090 GPU 환경에서 초당 30 프레임(30fps)의 실시간 추론 속도를 달성하여, 가상 아바타(virtual avatars), 라이브 스트리밍(live streaming), 증강현실(augmented reality) 등 다양한 분야에서 실시간으로 고품질 비디오 챗(video-chat)을 지원할 수 있는 효과적인 해결책을 제공한다.